Histoire de l’ordinateur

Des salles remplies de lampes à l’ENIAC

Au milieu des années 1940, l’ENIAC, construit aux États‑Unis par John Mauchly et J. Presper Eckert, est considéré comme le premier ordinateur électronique numérique généraliste. Cette machine de plus de 30 tonnes, remplie de milliers de tubes à vide, effectue en quelques secondes des calculs qu’un humain mettrait des heures à réaliser, marquant le début de l’ère informatique.

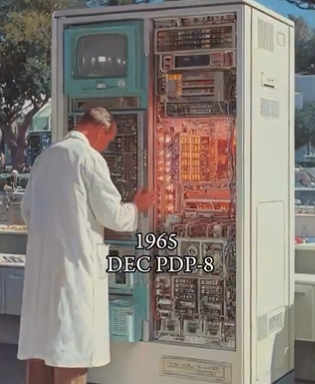

Des tubes aux transistors et circuits intégrés

Dans les années 1950, les transistors remplacent les lampes, rendant les ordinateurs plus fiables, plus petits et moins gourmands en énergie. Les circuits intégrés des années 1960 regroupent ensuite des dizaines puis des milliers de composants sur une seule puce, ouvrant la voie aux premiers mini‑ordinateurs et aux systèmes utilisés dans l’industrie, la recherche et les administrations.

L’arrivée de l’ordinateur personnel

Dans les années 1970‑1980, l’invention du microprocesseur permet de mettre un ordinateur complet sur une seule puce, donnant naissance aux premiers PC comme l’Apple II et l’IBM PC. L’interface graphique et la souris popularisent l’informatique domestique, tandis que les réseaux se développent et préparent l’émergence d’Internet.

Internet, mobilité et cloud

À partir des années 1990, le Web connecte les ordinateurs du monde entier et transforme l’informatique en outil de communication et d’information de masse. Au début des années 2000, smartphones, tablettes et services de cloud computing déplacent la puissance de calcul vers des centres de données, rendant l’accès aux applications et aux données possible partout et à tout moment.

L’ère de l’IA et des supercalculateurs

Aujourd’hui, les ordinateurs vont des microcontrôleurs embarqués aux supercalculateurs capables de réaliser des billions d’opérations par seconde, soutenant la recherche scientifique, la finance ou encore la météo. L’intelligence artificielle, le calcul en périphérie (edge) et les premières expériences en informatique quantique redéfinissent ce que les machines peuvent apprendre, prédire et optimiser dans notre vie quotidienne.

L’ordinateur quantique

Les ordinateurs quantiques représentent une nouvelle étape dans cette évolution, en exploitant les lois de la mécanique quantique pour résoudre certains problèmes beaucoup plus rapidement que les machines classiques. Au lieu de bits valant 0 ou 1, ils utilisent des qubits qui peuvent être simultanément dans plusieurs états (superposition) et corrélés entre eux (intrication), ce qui leur permet d’explorer un grand nombre de possibilités en parallèle. Bien que la technologie soit encore expérimentale et limitée à des prototypes de quelques centaines de qubits, elle ouvre déjà des perspectives dans des domaines comme la cryptographie, la chimie, l’optimisation ou l’intelligence artificielle, et pourrait transformer en profondeur l’informatique dans les prochaines décennies.